티스토리 뷰

우선 밑의 방법을 하기전 나의 추천방법은 Docker를 이용해서 환경설정하는 것을 적극추천한다

해당 방법은

https://dolgogae.tistory.com/8

Docker Container를 이용한 CUDA - Tensorflow 연동하기

Tensorflow-gpu installation using Docker 도커는 컨테이너를 사용하여 Tensorflow 설치를 나머지 시스템에서 격라하는 가상 환경을 만듭니다. TensorFlow 프로그램은 호스트 머신과 리소스를 공유(디렉터리 액

dolgogae.tistory.com

여기에 포스팅해놨으니 적극 활용해보자~~!!

[컴퓨터 사양]

cpu - 라이젠 4세대 5600x

memory - 16g * 2

gpu - rtx 3070

우분투 18.04버전을 설치할 때 nvidia driver와 cuda가 충돌하는 것 때문에 고생을 많이했고, nvidia driver를 설치하면 cuda가 삭제되고 cuda를 설치하면 nvidia driver가 삭제되는 문제가 있었다....(nvidia-smi와 nvcc -V가 절대 동시에 나오질 않는....)

어디인지 모르지만 우분투를 20.04버전을 설치하면 해결된다고 본 것 같아 바로 버전을 업데이트 했고, 해결했다.

1. 기존 nvidia driver, CUDA 삭제

sudo apt-get remove --purge '^nvidia-.*'

sudo apt-get autoremove --purge 'cuda*'

2. CUDA 설치 및 확인

$ sudo apt install nvidia-cuda-toolkit

$ nvcc -V

nvcc: NVIDIA (R) Cuda compiler driver

Copyright (c) 2005-2019 NVIDIA Corporation

Built on Sun_Jul_28_19:07:16_PDT_2019

Cuda compilation tools, release 11.1, V10.1.243

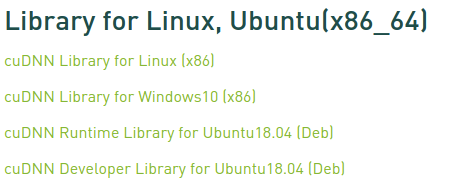

3. cudnn 설치 및 CUDA 연동

cuDNN Archive

NVIDIA cuDNN is a GPU-accelerated library of primitives for deep neural networks.

developer.nvidia.com

내 버전은 위에서 보듯 11.1 이므로 최신버전인 v8.1.0을 설치했다.

- 압축해제

$ tar -xvzf cudnn-10.1-linux-x64-v7.6.5.32.tgz- cuDNN 연동

# 복사

$ sudo cp cuda/include/cudnn.h /usr/lib/cuda/include/

$ sudo cp cuda/lib64/libcudnn* /usr/lib/cuda/lib64/

# 권한설정

$ sudo chmod a+r /usr/lib/cuda/include/cudnn.h

$ sudo chmod a+r /usr/lib/cuda/lib64/libcudnn*

4. 환경변수 등록하기

$ sudo vim ~/.bashrc

맨 아래줄에 입력해줍니다.

#=================================================================

#CUDA ENV

export LD_LIBRARY_PATH=/usr/lib/cuda/lib64:$LD_LIBRARY_PATH

export LD_LIBRARY_PATH=/usr/lib/cuda/include:$LD_LIBRARY_PATH

+ 추가사항

우분투의 경우에는 nvidia driver를 설치해주지 않으면 해상도가 깨져서 나오기 때문에 사실상 필수(?)라고 할 수 있는 nvidia driver를 설치하는 것을 권장한다.

$ ubuntu-drivers devices

== /sys/devices/pci0000:00/0000:00:03.1/0000:2b:00.0 ==

modalias : pci:v000010DEd00002484sv000010B0sd00002484bc03sc00i00

vendor : NVIDIA Corporation

driver : nvidia-driver-460-server - distro non-free

driver : nvidia-driver-460 - third-party non-free recommended

driver : xserver-xorg-video-nouveau - distro free builtin저 같은 경우는 nvidia-driver-460이 추천으로 나왔기 때문에 저걸로 설치 해줬습니다.

$ sudo apt install nvidia-driver-460

$ sudo reboot

$ nvidia-smi

+-----------------------------------------------------------------------------+

| NVIDIA-SMI 460.67 Driver Version: 460.67 CUDA Version: 11.2 |

|-------------------------------+----------------------+----------------------+

| GPU Name Persistence-M| Bus-Id Disp.A | Volatile Uncorr. ECC |

| Fan Temp Perf Pwr:Usage/Cap| Memory-Usage | GPU-Util Compute M. |

| | | MIG M. |

|===============================+======================+======================|

| 0 GeForce RTX 3070 Off | 00000000:2B:00.0 On | N/A |

| 0% 37C P8 22W / 220W | 593MiB / 7959MiB | 30% Default |

| | | N/A |

+-------------------------------+----------------------+----------------------+

+-----------------------------------------------------------------------------+

| Processes: |

| GPU GI CI PID Type Process name GPU Memory |

| ID ID Usage |

|=============================================================================|

| 0 N/A N/A 1094 G /usr/lib/xorg/Xorg 90MiB |

| 0 N/A N/A 1660 G /usr/lib/xorg/Xorg 268MiB |

| 0 N/A N/A 1789 G /usr/bin/gnome-shell 65MiB |

| 0 N/A N/A 2195 G ...AAAAAAAAA= --shared-files 155MiB |

+-----------------------------------------------------------------------------+

'AI > setup' 카테고리의 다른 글

| RTX-30xx GPU에서 CUDA 인식을 잘 못할때 해결법(+ Tensorflow gpu 연결 확인) (0) | 2021.06.24 |

|---|

- Total

- Today

- Yesterday

- Container

- API

- Java

- backend

- apache kafka

- Data Engineering

- rhel

- JPA

- OS

- 리액트

- caching

- Front

- NextJS

- K8S

- Producer

- spring boot

- centos

- 프론트엔드

- Linux

- frontend

- spring

- broker

- apache

- KAFKA

- feign client

- consumer

- zookeeper

- cs

- Firebase

- React

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |